最近DeepSeek大火,我也来跟风凑热闹。可能是由于使用的人太多,官方的网页版经常用不了,本地部署671B也不现实,于是我就尝试了qwen蒸馏的14B。硬件配置方面,我是在R9000P 2021上面运行,显卡是6G显存的3060,内存是32G,系统是win10。

首先下载安装ollama,然后运行 [ollama pull deepseek-r1:14b] 来下载模型。不知道为什么ollama的下载速度越往后越慢,这时候可以通过ctrl-c先中断下载,再次运行pull(断点续传下载),这时候就可以暂时恢复速度,后面速度下来了再重复这个操作就行。

下好之后直接运行 [ollama run deepseek-r1:14b] 就可以开始对话了。当然这是在命令行下,不方便直接看markdown格式的回答,这时候可以使用一些GUI客户端,例如Open WebUI和Cherry Studio。我觉得Cherry Studio比较方便,下载portable的exe就可以直接运行了。

不过我现在用的比较多的还是Open WebUI,这个用起来会稍微麻烦一些。首先使用 [pip3 install open-webui] 来安装,如果出现编译错误的情况,还需要安装VS的C++编译器和SDK。装好之后运行 [open-webui serve] 来启动服务,随后在浏览器访问localhost:8080即可。

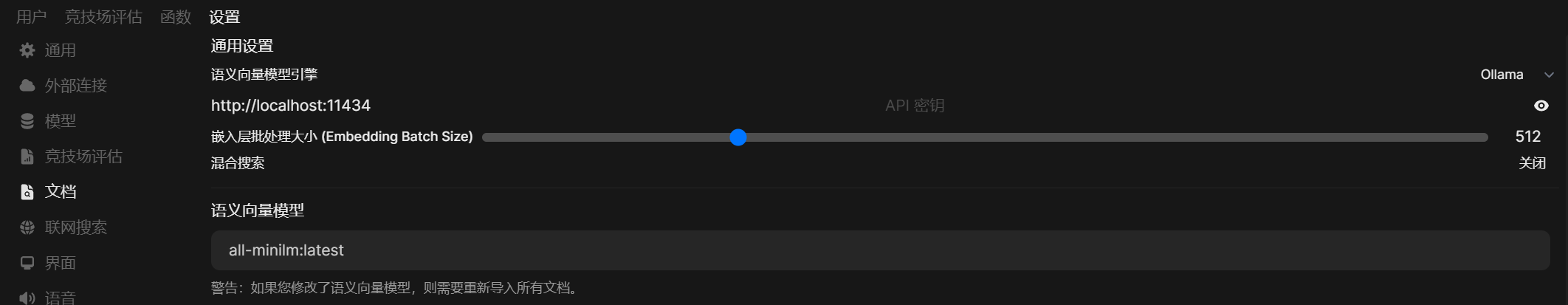

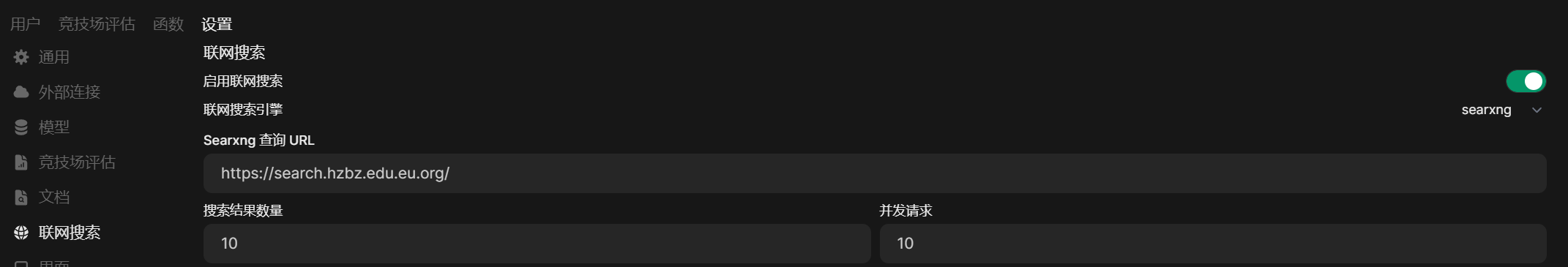

Open WebUI还支持文件上传和联网搜索,不过需要先配置embedding模型。在 管理员设置-文档 中可以选择embedding模型,我平时主要用all-minilm或者bge-m3,也都是通过ollama运行的。联网搜索我使用的是searxng,现在用的是论坛里其他用户部署的searxng服务,以后也打算试试本地自建。

需要注意的是,联网搜索时可能会访问一些不能直连的网站,需要配置一下代理。可惜Open WebUI里面不能直接配置代理(Cherry Studio可以,但它又不支持联网搜索),需要设置系统代理或者用Proxifier来配置代理。不过我试用了几次,发现联网搜索功能也不是很好用,一个主要原因是消耗的时间太长,联网结果也并没有那么好。不过目前我本地部署就只是玩玩,不用联网搜索也没关系。